AIは、入力した大量の情報を手がかりに、一つ一つ段階を踏んで改善策を導いていきます。富士通研究所が開発したAIは、何をどのような順序で変えればいいという手順を、誰でも分かるように見える化し、結論に至った理由を説明できるようにしています。米国人工知能学会が2月上旬に開催した国際会議で、発表して高い評価を得ています。

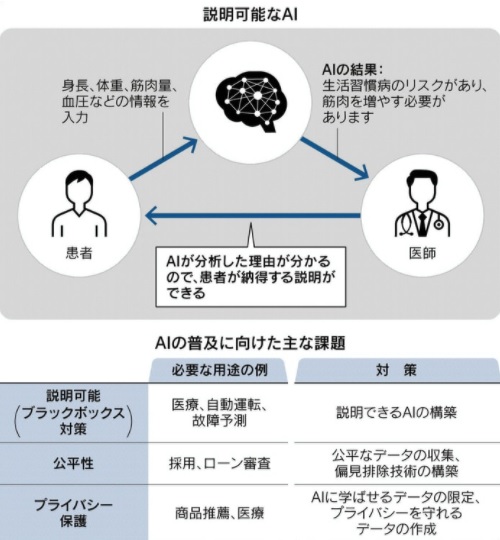

健康診断の例を挙げると、患者は身長や体重、筋肉量、血圧といった情報を医者を通じてAIに入力します。AIが分析したところ、生活習慣病のリスクがあり、筋肉量を先に1㎏増やしてから、体重を1㎏増やす必要があるとの結果が出ます。これまでの説明可能なAIは、結論に至った根拠を示すだけで、改善のためにどの程度筋肉などを増やせばいいかは分かりませんでした。ところが富士通のAIは、筋肉などをどれだけ増やせばリスクは減るかといった具体的な手順を詳しく示しています。

人間は、説明から逃げたり、煙に巻く説明に終始したりすることは少なくありません。将来はAIが人間より納得いく説明ができると評価されるかもしれません。AIが判断の根拠を説明せずに、効率性を高めることが許される内容なのか、人の生命や将来が決まるような判断なのかを見極める必要があります。AIは急速に進歩しており、普及に向けた課題は説明責任だけではありません。判断の公平性とプライバシーの保護も解決しなければなりません。

説明できるAIは、XAI (Explainable AI)とも呼ばれます。AIが自ら情報を集めて学習し結論を出すようになり、人間からはどうしてそんな結論を出したか分からなくなっています。結論につながった根拠を明らかにすることで、AIの透明性と信頼性を高められることになります。

(2021年2月26日 日本経済新聞)

(吉村 やすのり)